经常有小伙伴需要将互联网上的数据保存的本地,而又不想自己一篇一篇的复制,我们第一个想到的就是爬虫,爬虫可以说是组成了我们精彩的互联网世界。

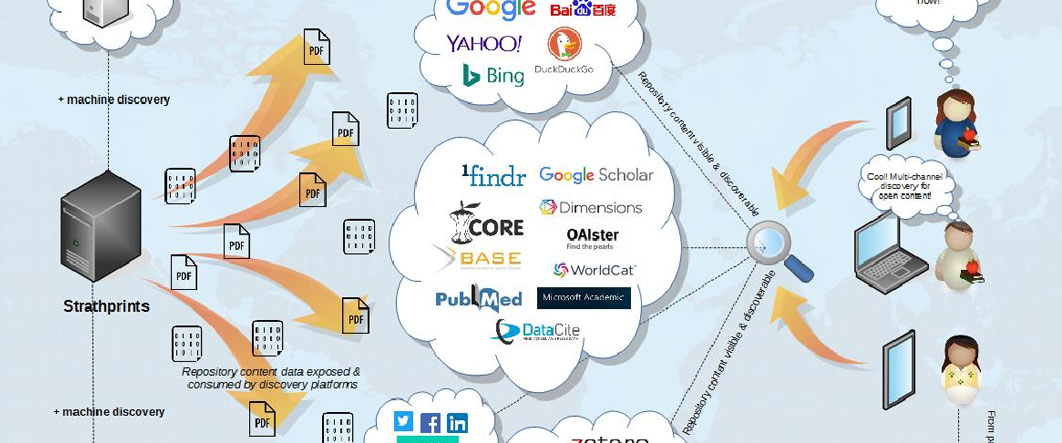

网络搜索引擎和其他一些网站使用网络爬虫或蜘蛛软件来更新他们的网络内容或其他网站的网络内容索引。网络爬虫复制页面以供搜索引擎处理,搜索引擎对下载的页面进行索引,以便用户可以更有效地搜索。

这都是爬虫数据采集的功劳。这篇文章我总结了爬虫数据采集的说有流程,从最开始的最简单的基本爬虫,到爬虫所采集到的数据如何存储,以及我们如何绕过一些反爬措施,来获取我们需要的数据,进行爬虫的数据采集:

-

爬虫介绍:主要介绍了什么是爬虫,以及爬虫可以干什么?

-

爬虫所带来的道德风险与法律责任:这篇文章主要介绍了我们在做数据采集的时候,什么可以采集,什么不能采集,由于不当采集给我们带来的法律风险,我们需要注意的一些问题。

-

连接网站与解析 HTML:这篇文章主要介绍了我们如何使用爬虫去连接网站,并将网站我们需要的内容解析出来。

-

数据采集:这篇文章以一个博客网站为实例,讲解了如何使用爬虫采集网站的内容,并获取我们需要的信息,可以作为一个练手项目。

-

使用 API:我们在进行数据采集的时候,另外的一种方法,可以大大简化我们数据采集的难度,同时有些网站只提供 API 我们应该如何去获取数据。

-

存储媒体文件:这篇文章详解介绍了如何通过爬虫采集媒体文件,包括:图片、音频、视频等信息,采集之后我们如何保存。

-

存储 CSV 文件:这篇文章介绍了如何将爬虫采集到的数据保存为 csv 文件,为我们后面的数据分析或者其他的一些要求做好铺垫。

-

使用 MySQL 存储数据:这篇文章详细介绍了如何将爬虫采集到的数据保存到数据库,可以提供给我们查询或者是分析等任务。

-

读取文档:这篇文章介绍了如何解析文档内容,并读取内容。

-

读取 CSV、PDF、Word 文档:这篇文章详细介绍了如何读取 CSV、PDF、Word 文档,以及具体的 Python 代码演示。

-

数据清洗:这篇文章主要介绍了我们采集的数据,如何清洗大做进一步的处理,来达到项目的要求。

-

数据标准化:这篇文章主要介绍了数据清洗之后如何标准化,来达到可以做数据分析的要求。

-

穿越网页表单与登录窗口进行采集:这篇文章主要介绍了如何自动登录,采集登录之后的内容。

-

穿越网页表单与登录窗口进行采集(二):穿越网页表单与登录窗口进行采集这篇文章的续作。

-

采集 JavaScript:这篇文章主要介绍了如何采集由 JavaScript 生成的内容, JavaScript 生成的内容不同于直接渲染的内容,普通抓取方式无法获得内容。

-

在 Python 中用 Selenium 执行 Javascript:这篇文章主要介绍了在 Python 中用 Selenium 配合浏览器执行 Javascript,给我们大面积采集 Javascript 生成内容成为可能。

-

图像识别与文字处理:这篇文章主要介绍了图片处理与文字识别说需要的基础环境搭建,为后面识别验证码做铺垫。

-

处理格式规范的文字:这篇文章主要介绍我们对于互联网上有些内容做成图片的方式,防止我们采集,我们应该如何识别这篇图片上的文字。

通过以上这 18 篇文章,整个一个爬虫采集流程都详细的介绍了,几乎涉及到爬虫采集的方方面面。