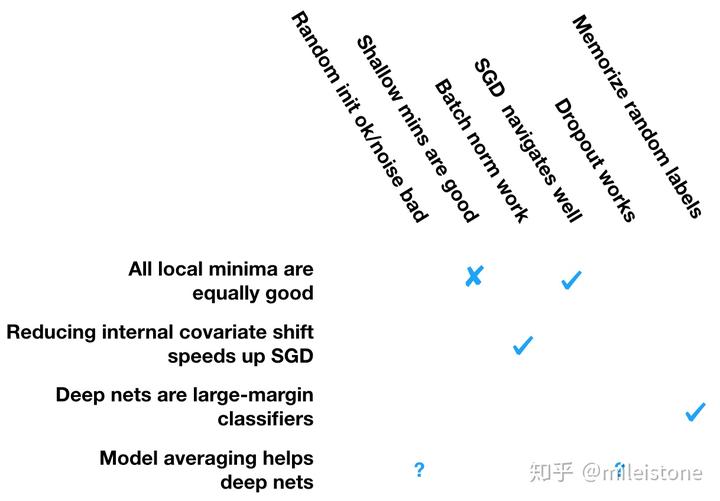

神经网络黑箱的意思是我们知其然,不知其所以然,相关理论比较缺乏。别看神经网络相关论文汗牛充栋,但是大部分类似于 technical report,告诉你我这么做效果不错,具体原因不知道,只能“guess”,所以很容易被打脸。

这一篇文章讲得挺好的,他用光学类别深度学习,非常形象。

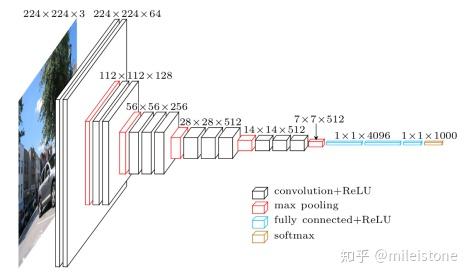

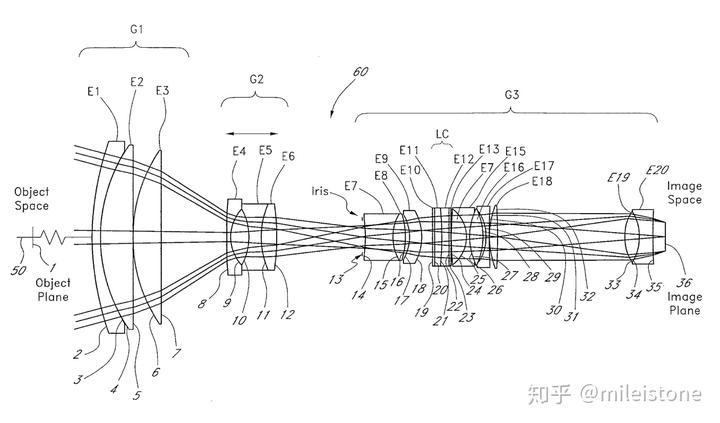

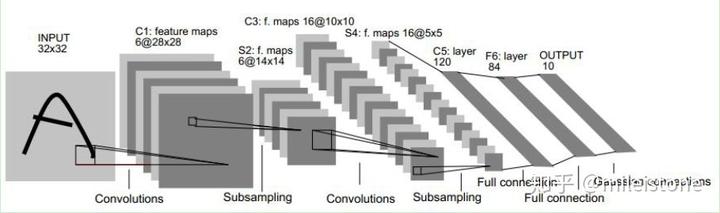

从结构来看,无论是深度学习还是镜头,都是一层一层叠起来的,如下图所示。

从设计流程来看,当要设计一个镜头的时候,往往以一个已知的镜头组合作为基础,这个已知的镜头组合一般都以发明这个镜头组合的人命名,类似于深度学习的里面的 LeNet、AlexNet。然后你跑个仿真,看看这个基础镜头组合的表现和你需要达到的要求存在哪些差距,在合适的地方插入合适的组件来磨平差距。接着,你用一个数值优化器来调上述镜头组合的参数,以发挥上述镜头组合最大的功效。这个类似于深度学习里面的优化和调超参过程。

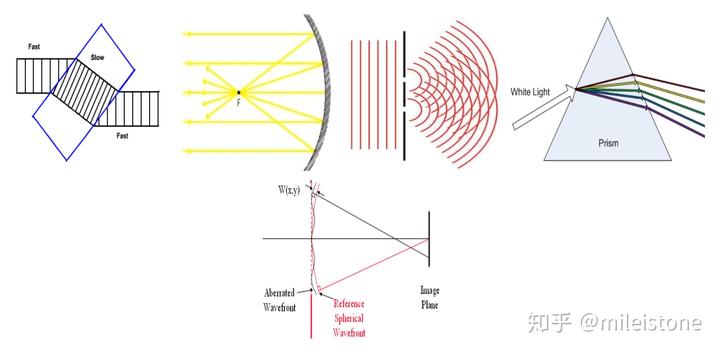

从系统组成部件来看,光学组件有的起到反射作用,有的起到衍射作用,有的起到折射作用,有的起到散射作用,有的起到相位校正作用等等。深度学习组件(conv、pool、relu 等等)有的起到学习空间相关作用,有的起到防止过拟合作用,有的起到增加非线性作用等等。

从发展历史来看,伽利略时代虽然没有光学理论,类似于现在的深度学习,但是同样造出来了人类历史上第一架天文望远镜,推动了天文学的发展。现在深度学习也理论不足,但是极大地推动了人工智能的发展。

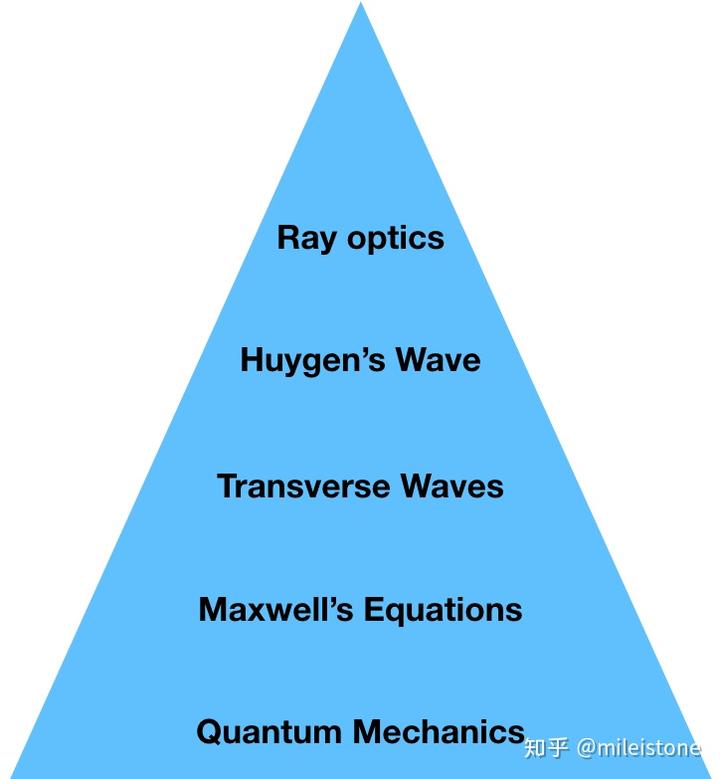

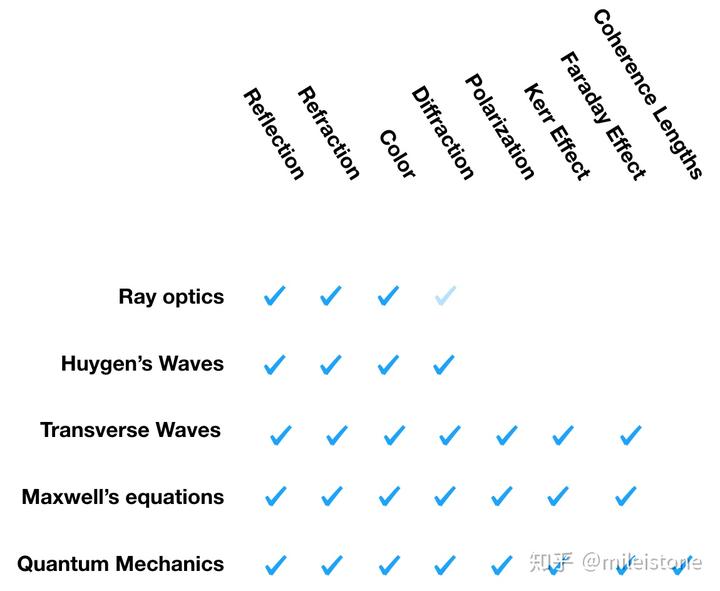

从结果看,在几百年里,经过科学家的不懈努力,光学终于形成了一整套比较完备的体系,使得现在的光学工程师在设计镜头的时候有迹可循,而不是像几百年前的伽利略一样靠经验设计。这一套完备的体系将光学分层了,如下图所示,这样的分层使得光学分工明确,每个人研究各自层的东西,一起推动光学发展。上面的层是下面层的抽象,越往上能解释越复杂的现象,见下图所示,而相比而言深度学习里面的很多现象还得不到较好的解释。

光学也经历过黑箱时代,深度学习现在就是黑箱时代,理论的前进一般会晚于实践,但是假以时日,理论肯定会完备起来,形成类似于当前光学那样的层层抽象的学术体系,只不过这个过程需要所有从业者一起的努力,和一定时间的积淀,也许几十年,也许上百年。